Welche Vorteile bietet die Edge-Cloud?

Es steht eine neue Generation cloudnativer Anwendungen in den Startlöchern, die besonders hohe Ansprüche an das Computing und die Latenzzeit stellen. Mitch Simcoe von Ciena erklärt, wie durch den Umstieg auf eine Edge-Cloud-Architektur eine ganze Reihe von neuen Anwendungsfällen adressiert werden kann.

Dies ist der erste Teil einer Beitragsreihe über die Edge-Cloud. Den zweiten Teil, Auf zu neuen Gestaden mit der Edge-Cloud, können Sie ebenfalls lesen.

Cloud-Services sind allgegenwärtig. Von einzelnen Benutzern, die sich exzessiv Over-The-Top (OTT)-Videoinhalte anschauen, bis hin zu Unternehmen, die Software-as-a-Service (SaaS)-Lösungen einsetzen – immer sind es Cloud-Services, über die Menschen und Unternehmen Inhalte konsumieren und Anwendungen nutzen. Schon seit Jahren ermöglichen zentrale Rechenzentren und Cloud-Architekturen den Zugriff auf diese Services und stellen die entsprechende Infrastruktur bereit.

Doch heute entsteht im Entertainment-Bereich sowie im Handel, in der Produktion und im Automobilsektor eine neue Generation cloudnativer Anwendungen, die häufig einen deutlich höheren Computing-Aufwand verursachen und sehr latenzsensibel sind. Traditionelle, zentral strukturierte Cloud-Architekturen können die Erwartungen, die in Bezug auf die Quality of Experience (QoE) an diese Anwendungen gestellt werden, nicht erfüllen, sodass ein dynamischeres, dezentrales Cloud-Modell erforderlich ist.

Um die erwartete QoE zu gewährleisten, müssen die Ressourcen für das Computing und das Speichern in der Cloud daher näher an den Edge des Netzes rücken, wo die Inhalte sowohl von Menschen als auch von Maschinen erzeugt und konsumiert werden. Diesen neuen Ansatz bezeichnet man als Edge-Cloud, bei der das Networking für Speicherung und Computing am Edge erfolgt.

Dies ist der erste Teil einer Beitragsreihe über die treibenden Branchenfaktoren, Herausforderungen und Möglichkeiten, die sich durch die Edge-Cloud ergeben. In diesem Teil wird erklärt, wie sich die Akteure in diesem Umfeld auf eine Verschiebung zentraler Cloud-Funktionen hin zum Edge vorbereiten müssen.

Was genau ist die Edge-Cloud?

Ciena definiert die Edge-Cloud als eine Cloud-Umgebung, die sich physisch in größerer Nähe zu den Endbenutzern (Menschen und Maschinen) befindet und sogenannte Commodity-Off-the-Shelf (COTS)-Komponenten (d. h. serienmäßige Komponenten) für Computing und Speicherung in Verbindung mit hoch skalierbaren und programmierbaren Networking-Komponenten umfasst. Diese Komponenten sind miteinander verbunden und bilden eine Edge-Cloud, die global mit dem übrigen Netz aus ganz traditionell zentral ausgelegten Rechenzentren verbunden ist. Sie müssen daher anwendungsorientiert sein, damit die Erfassung und Anpassung an sich ständig ändernde Anforderungen sicher und in Echtzeit erfolgen kann.

Für eine andere Betrachtung der Edge-Cloud kann auf eine Analogie aus der physischen Welt zurückgegriffen werden. E-Commerce-Unternehmen, wie beispielsweise Amazon, wickelten den Warenversand ganz zu Beginn noch ausgehend von einem Lager ab, das sich in der Nähe der Unternehmenszentrale, beispielsweise in Seattle, befand. Auf regionaler Ebene funktionierte das recht gut, aber als Folge der landesweiten Expansion konnte das Unternehmen die Erwartungen der Kunden in Bezug auf die Lieferzeiten nicht mehr erfüllen. Um die Lieferzeiten (in Analogie zur Latenzzeit des Netzes) deutlich zu verkürzen, richtete das Unternehmen überall in den USA Versandlager in größerer Nähe zu den Kunden ein und hält die Waren (in Analogie zu den Inhalten) jetzt lokal vor. Die lokalen Versandlager in ihrer physischen Form entsprechen den Rechenzentren am Edge. Das Unternehmen nutzt das Konzept maximal aus und hat inzwischen sogar kleine Warenlager in Manhattan eingerichtet, um die Lieferzeiten für einige Produkte von mehreren Tagen auf wenige Stunden zu senken.

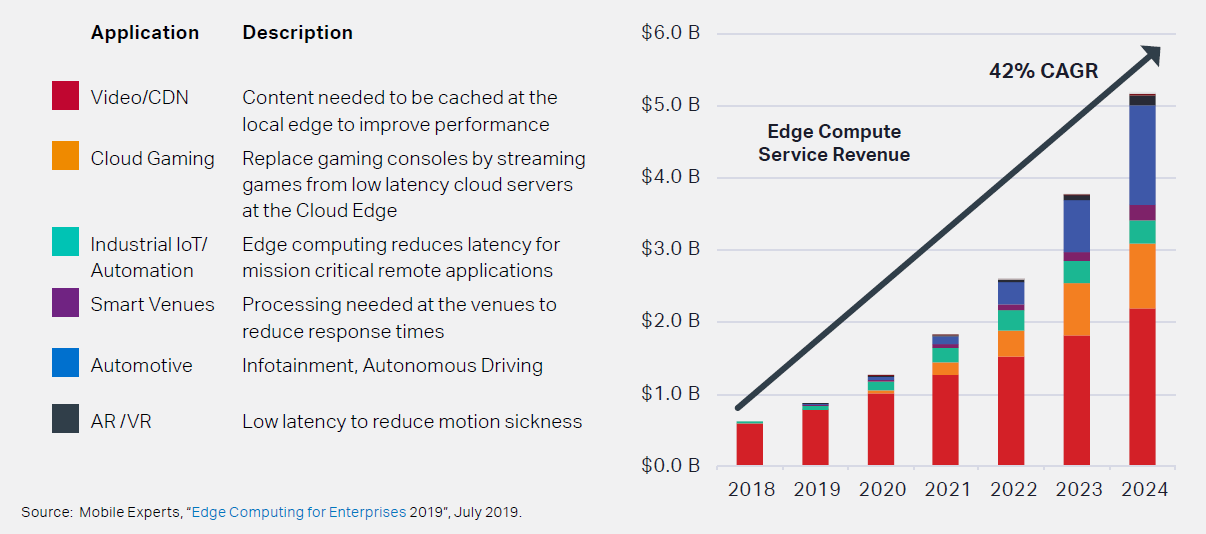

Welche Anwendungen würden also ganz besonders von der Edge-Cloud profitieren?

Immer mehr Anwendungen benötigen Echtzeit-Latenz. Aus Unternehmenssicht steht dabei nicht nur das Verbraucherverhalten im Vordergrund. Vielmehr optimieren viele Unternehmen ihre betrieblichen Abläufe, um eine verbesserte Kundenerfahrung zu gewährleisten. Beispiele für neu aufkommende Anwendungsfälle, die besonders bandbreiten- und latenzzeitabhängig sind:

Betrachten wir einige dieser Anwendungen aus dem Verbraucher- und Unternehmensbereich genauer:

1) Video-Streaming/Bereitstellung von Inhalten

Da immer mehr Live-Inhalte und aufgezeichnete Videos von Nutzern sowohl zuhause als auch unterwegs über ihre mobilen Geräte gestreamt werden, müssen diese Inhalte näher in Richtung der Nutzer verschoben werden, um die Leistung zu verbessern und die Networking-Kosten für die Langstreckenverbindungen zu optimieren. Die Nutzung von sogenannten Content Delivery Networks (CDN) und das lokale Caching waren bisher traditionelle Anwendungsfälle für die Speicherung am Edge, wo beliebte Inhalte in Edge-Rechenzentren, also sehr nah an dem Ort, an dem die Endbenutzer die Inhalte konsumieren, gecacht werden.

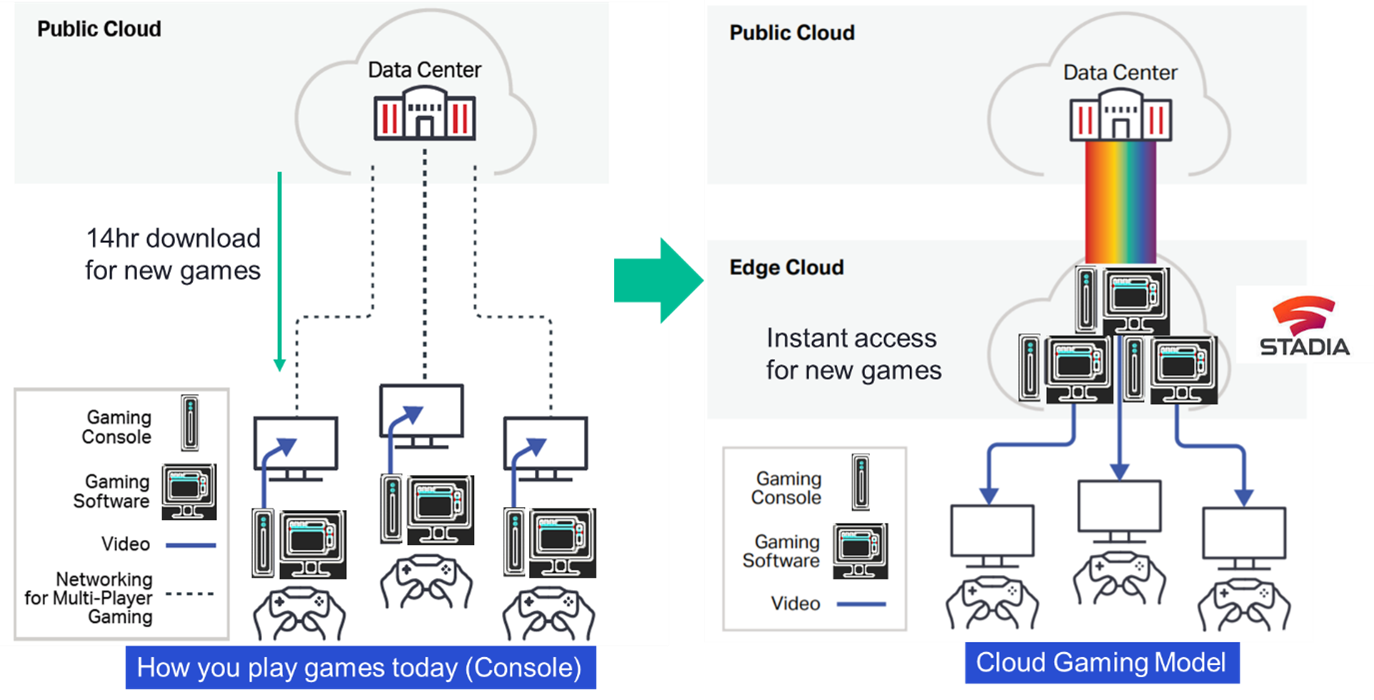

2) Cloud-Gaming

In einem Cloud-Gaming-Szenario würden die Gamer keine dedizierte Hardware, wie traditionelle Gaming-Konsolen, mehr benötigen. Sie würden Spiele weiterhin mit Gaming-Controllern spielen, wären dabei jedoch mit einer Gaming-App auf dem Gerät ihrer Wahl (Tablet, Computer oder Smartphone) verbunden. In einem Edge-Computing-Modell werden die Gaming-Video-Inhalte von einem Server in einem Edge-Computing-Rechenzentrum auf die Geräte der Gamer gestreamt. Um eine Leistung zu erzielen, die der eines lokalen Gaming-Setups entspricht, werden am Cloud-Edge sowohl niedrige Latenzzeiten als auch die entsprechende Bandbreite für die Gaming-Videos (immer häufiger in 4K) benötigt.

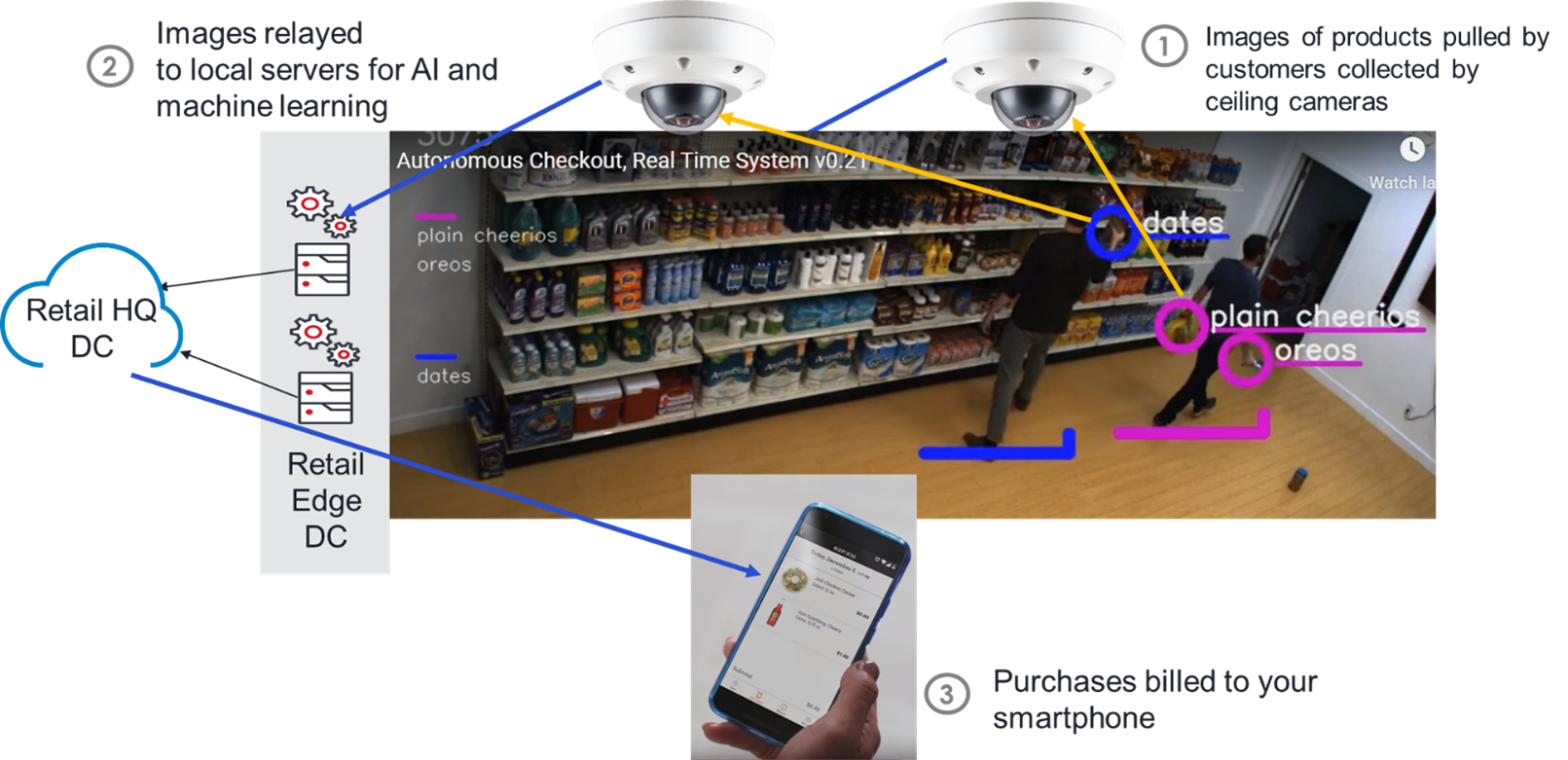

3) Kassenlose Geschäfte

Es gibt einen neuen Ansatz, bei dem Einzelhändler (wie zum Beispiel „Amazon Go“-Shops) Kameras in die Deckenverkleidung der Geschäfte integrieren, um Bilder von den Kunden beim Einkauf zu erfassen. Diese Bilder werden dann mithilfe von KI analysiert, um zu bestimmen, für welche Waren sich die Käufer entschieden haben. Die Käufer müssen am Ausgang nicht länger eine Kasse passieren. Stattdessen wird ihre Kreditkarte direkt mit den Kosten für die erworbenen Waren belastet. Zur Durchführung dieser nahezu in Echtzeit ablaufenden Bildverarbeitung und somit zur Gewährleistung einer nahtlosen Kundenerfahrung werden in den Geschäften selbst bzw. am Edge umfassende Computing- und Speicher-Ressourcen benötigt.

(Bildquelle: https://www.youtube.com/watch?v=yeS8TJwBAFs)

4) Autonomes Fahren

Obwohl davon ausgegangen wird, dass autonome Fahrzeuge große Mengen Daten verarbeiten werden, die von Sensoren innerhalb der Fahrzeuge stammen, muss jedoch immer auch eine Untermenge von Daten zu benachbarten Fahrzeugen und von an der Straße angeordneten Sensoren verarbeitet werden, um Informationen über Staus und den Straßenzustand zu erfassen und Unfälle zu verhindern. Die Latenzzeit für die Verarbeitung dieser Daten und die Rücksendung der entsprechenden Informationen zu den Fahrzeugen, die darauf basierend Maßnahmen ergreifen müssen, muss im Bereich weniger Millisekunden liegen. Dafür wird ein Edge-Rechenzentrum in großer Nähe zum Benutzer benötigt, um diese SLA-Anforderungen der Anwendung zu erfüllen.

5) Industrial IoT/Smart Manufacturing

Hierbei handelt es sich um eine Initiative rund um Industrie 4.0, bei welcher der Fertigungsprozess in hohem Maße anpassbar und automatisierbar ist. Fertigungslinien werden mit Industrierobotern besetzt, deren Funktionen präzise über lokale Computing-Ressourcen gesteuert werden. Diese wiederum nutzen Machine Learning und KI zur Erkennung von Fehlern oder Mängeln, die während des Fertigungsprozesses auftreten, sowie zur entsprechenden Anpassung des Prozesses nahezu in Echtzeit. Um die Konnektivität innerhalb der Fertigungsanlagen zu vereinfachen, werden intelligente Industrieroboter über 5G verbunden (als Eigenversion oder über einen Betreiber). Dies erfordert niedrige Latenzzeiten und häufig eine Netzwerkleistung mit hoher Kapazität, um Fertigungsmängel so gering wie möglich zu halten und die Sicherheit der Mitarbeiter vor Ort zu maximieren.

All diese Anwendungen weisen eines der folgenden Cloud-Service-Merkmale auf, die den Edge-Computing-Bedarf erhöhen:

- Hohe Computing- und Speicheranforderungen für die auf KI und Machine Learning basierende Verarbeitung

- Niedrige Latenzzeiten (unter 10 ms) für alle Bereiche, in denen ein Benutzer-Feedback erforderlich ist

Wenn Sie mehr darüber erfahren möchten, wie Sie Ihre Edge-Cloud realisieren können, laden Sie sich unser Whitepaper Das Adaptive Network: Framework für ein Verständnis der Auswirkungen der Edge-Cloud auf das Networking herunter.