¿Cómo afectará la IA a las redes dentro y entre los centros de datos? Brian Lavallée de Ciena explica la importancia de las redes de alto rendimiento para aprovechar todo el potencial de la IA.

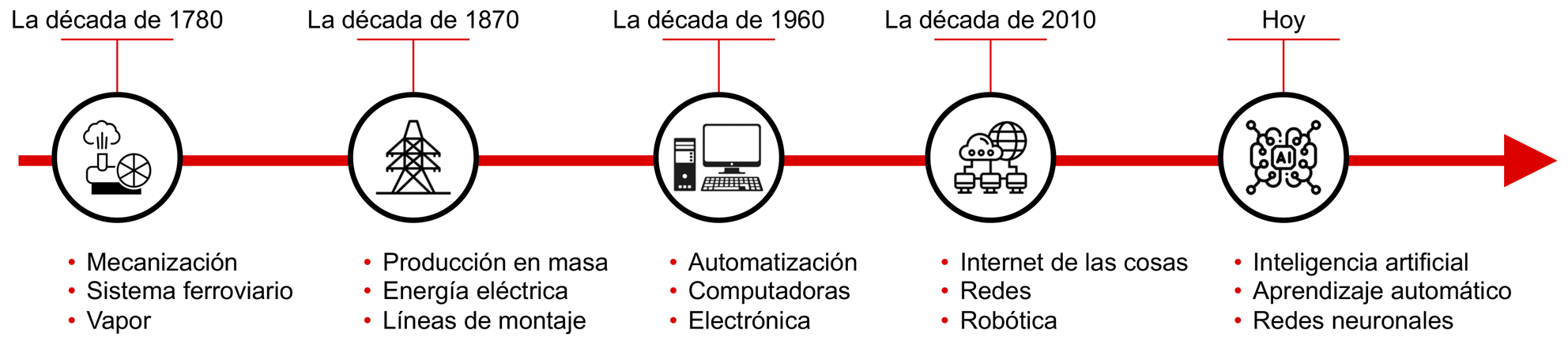

Aunque se ha generado un gran revuelo en torno a la inteligencia artificial (IA), no cabe duda de que la IA es real y ya está transformando significativamente una amplia gama de sectores, impulsando la innovación y la eficiencia a niveles antes inimaginables. Sin embargo, al igual que ocurre con la introducción de cualquier tecnología disruptiva, como las máquinas de vapor, la electricidad e Internet, la IA planteará oportunidades y desafíos únicos.

Figura 1: La inteligencia artificial (IA), un nuevo punto de inflexión tecnológico

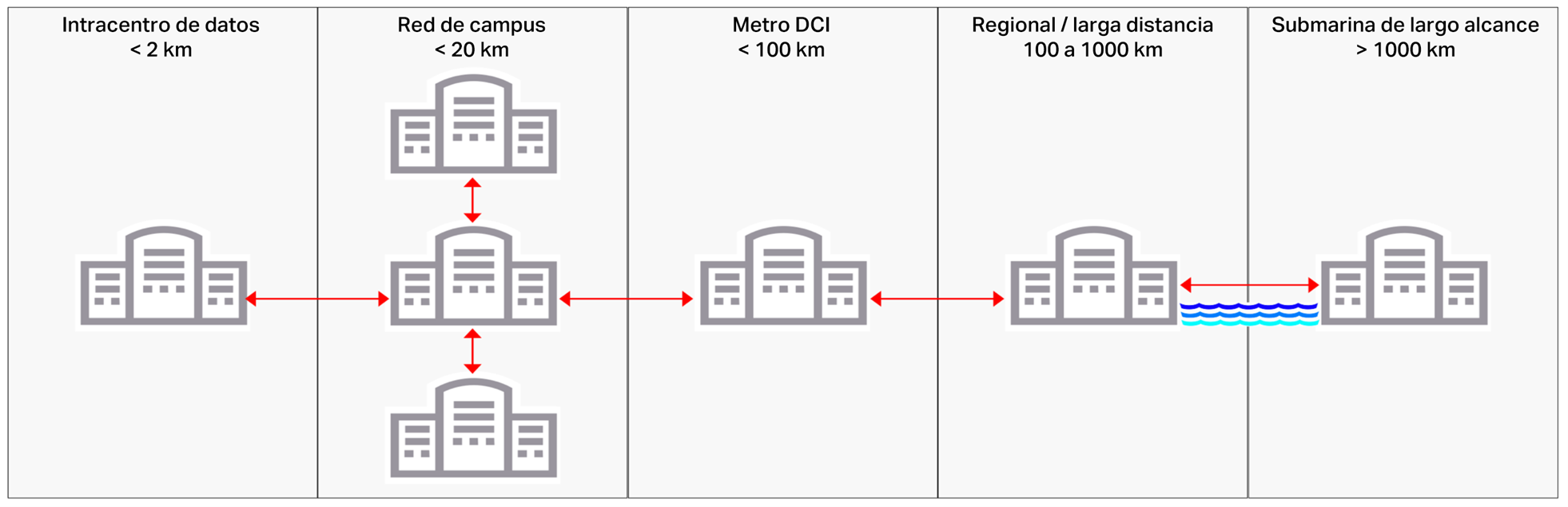

Los desafíos de la infraestructura de IA radican en ampliar de manera rentable la infraestructura de almacenamiento, computación y red, mientras se enfrentan los aumentos masivos del consumo de energía y la sustentabilidad a largo plazo. Para comprender mejor estos desafíos, analicemos cómo la IA afecta a las redes dentro de los centros de datos que alojan la infraestructura de IA y luego sigamos hacia el exterior, donde los centros de datos están conectados a distancias cada vez mayores.

Redes dentro del centro de datos para la inteligencia artificial

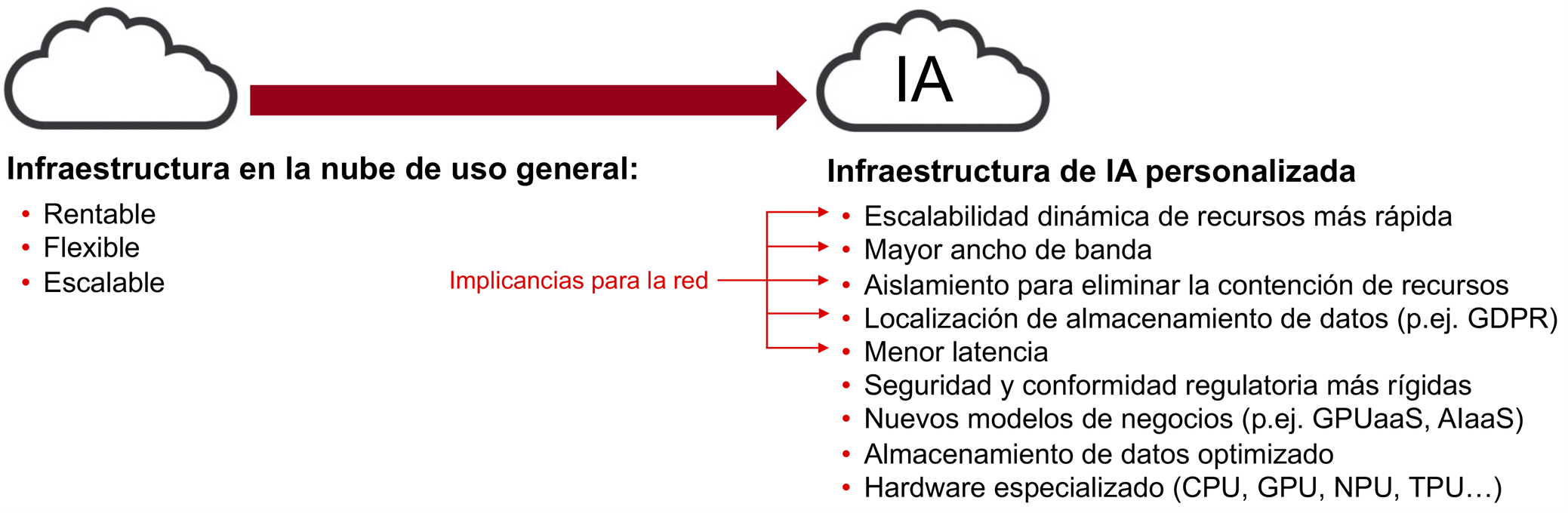

La IA nació en los centros de datos que alojan los servicios tradicionales en la nube que utilizamos diariamente en nuestra vida profesional y personal. Sin embargo, los requerimientos de la infraestructura de almacenamiento, computación y red de la IA pronto se volvieron demasiado complejos y exigentes para la infraestructura de nube tradicional en casos de uso como el entrenamiento de grandes modelos de lenguaje (LLM), la tecnología subyacente de las aplicaciones de IA generativa (GenAI), como el conocido ChatGPT. El éxito de la infraestructura de nube tradicional se basa en su rentabilidad, flexibilidad y escalabilidad, atributos que también son esenciales para la infraestructura de IA. Sin embargo, la IA necesita una gama nueva y más amplia de requerimientos de rendimiento de red, como puede verse en la figura 2. Hoy en día, la tecnología de infraestructura de IA es en su mayoría cerrada y patentada, pero el sector se ha unido para formar nuevos grupos de normalización, como el Ultra Ethernet Consortium (UEC) y el Ultra Accelerator Link (UALink) Promoter Group. Estos grupos buscan crear un ecosistema tecnológico más amplio para impulsar una innovación más rápida mediante una cadena de suministro de proveedores más segura.

Figura 2: Comparación de los requerimientos de infraestructura de la nube tradicional y la IA

Figura 2: Comparación de los requerimientos de infraestructura de la nube tradicional y la IA

Las aplicaciones de IA, como el entrenamiento de LLM a través del aprendizaje profundo (DL) y las redes neuronales artificiales, implican la transferencia de enormes cantidades de datos dentro de un centro de datos a través de redes cortas de gran ancho de banda y baja latencia que funcionan a velocidades de 400 Gb/s y 800 Gb/s hasta 1,6 Tb/s y más en el futuro. Así como se están desarrollando procesadores personalizados específicos para IA, como las unidades centrales de procesamiento (CPU) y las unidades de procesamiento gráfico (GPU), también es necesaria la innovación de la tecnología de redes para optimizar completamente la infraestructura de IA. Esto incluye avances en transceivers ópticos, conmutadores de circuitos ópticos (OCS), módulos combinados, unidades de procesamiento de red (NPU), plataformas basadas en estándares UEC y UALink y otras tecnologías de red.

Figura 3: La IA está impulsada por las redes de alto rendimiento tanto dentro de los centros de datos como entre ellos

Aunque estos avances en la tecnología de redes abordarán los desafíos de rendimiento de la IA, las enormes cantidades de espacio y consumo de energía asociadas conducirán a la creación e interconexión de muchos más centros de datos. Las distancias dentro de los centros de datos y entre ellos requerirán soluciones de red diferentes.

Redes de campus de IA

Una sola GPU moderna, el elemento fundamental de los clústeres de computación de IA, puede consumir hasta 1000 vatios, de modo que cuando se interconectan decenas o cientos de miles (y más) con fines como el entrenamiento de LLM, el consumo de energía asociado se convierte en un desafío monumental para los operadores de centros de datos. La nueva infraestructura de IA consumirá rápidamente energía y espacio en los centros de datos existentes. Esto conducirá a la creación de nuevos centros de datos en un “campus” donde los centros de datos están separados por menos de 10 kilómetros para minimizar la latencia y mejorar el rendimiento de las aplicaciones de IA. Los campus deberán estar situados cerca de fuentes de energía confiables, sustentables y rentables. Los centros de datos de los campus se conectarán entre sí y con centros de datos distantes mediante ópticas optimizadas para costos, energía, ancho de banda, latencia y distancias específicas.

Redes de interconexión de centros de datos (DCI)

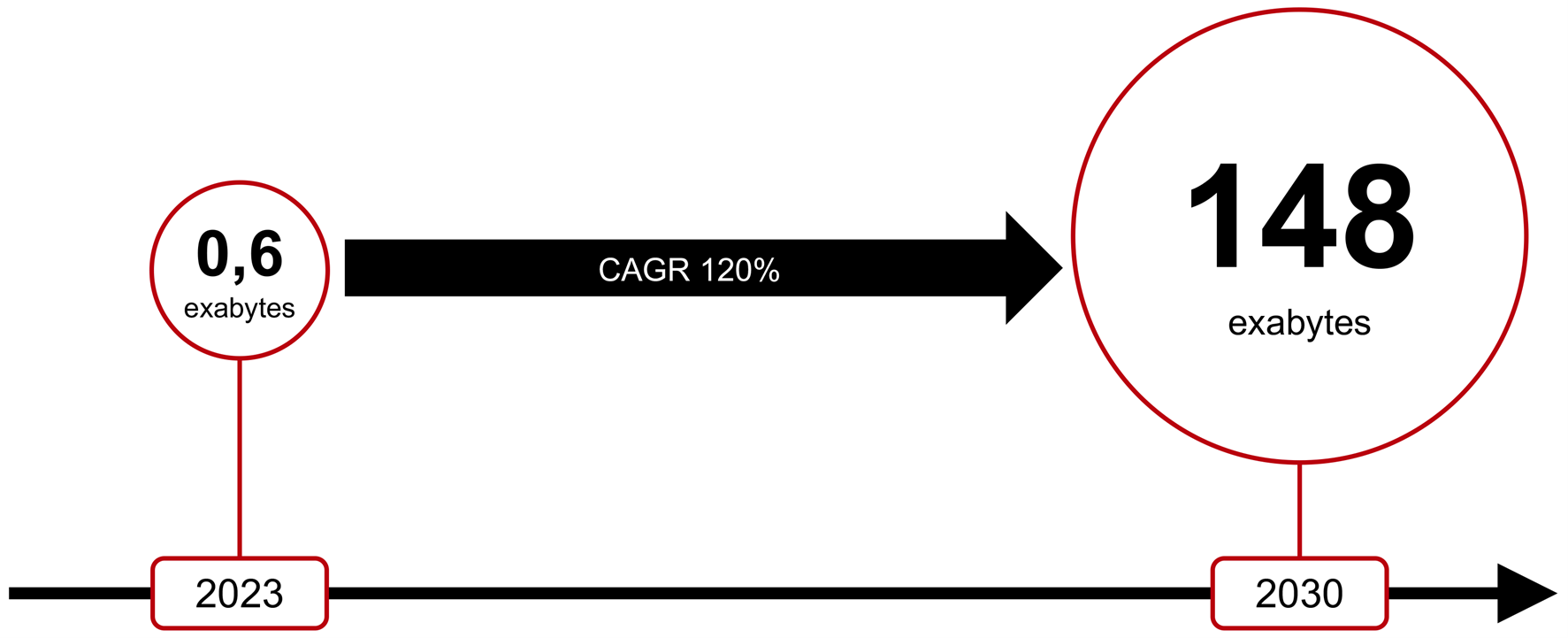

A medida que la infraestructura de IA se aloje en centros de datos nuevos y existentes, será necesario interconectarlos de manera similar a como se hace hoy en día con los servicios en la nube tradicionales. Esto se logrará utilizando soluciones de transporte óptico similares, aunque a tasas más altas, incluyendo 1,6 Tb/s, una primicia en el sector desarrollada por la tecnología WaveLogicTM 6 de Ciena. ¿De cuánto tráfico nuevo estamos hablando? Según un análisis reciente de la empresa de investigación Omdia, se prevé que el tráfico de red mensual potenciado por IA crezca aproximadamente un 120 % (CAGR) de 2023 a 2030, como se muestra en la figura 4. Este es un gran volumen de tráfico adicional que las redes globales deberán transportar en el futuro.

Figura 4: Previsión del crecimiento mensual del tráfico de red potenciado por IA de 2023 a 2030 (fuente: Omdia)

Para las empresas, la IA impulsará una necesidad cada vez mayor de migrar datos y aplicaciones a la nube por motivos económicos, la falta de experiencia propia en IA y las difíciles limitaciones de energía y espacio. A medida que los proveedores de servicios en la nube ofrezcan IA como servicio y GPU como servicio, el entrenamiento de LLM en la nube exigirá que las empresas trasladen grandes cantidades de datos de entrenamiento en forma segura entre sus instalaciones y la nube, así como entre diferentes instancias en la nube. Esto impulsará la necesidad de interconexiones de ancho de banda más dinámicas y de mayor velocidad, lo que requerirá más infraestructura de intercambio en la nube y representará una nueva oportunidad de generación de ingresos para las telcos.

Optimización del rendimiento de la IA en el borde de la red

Una vez que el LLM se ha entrenado correctamente, se optimizará y “podará” para que ofrezca una precisión de inferencia aceptable (es decir, usar IA en el mundo real) con un consumo mucho menor de recursos de computación, almacenamiento y energía. Estos algoritmos de IA optimizados se llevan al borde para disminuir la carga en los centros de datos en el núcleo que realizan el entrenamiento LLM, reducir la latencia y cumplir con las normativas relacionadas con la privacidad de los datos al alojar la información localmente. Colocar los activos de almacenamiento y computación de IA en centros de datos distribuidos geográficamente, más cerca de donde se crea y consume la IA, ya sea por humanos o máquinas, permite un procesamiento de datos más rápido para lograr la inferencia de IA casi en tiempo real. Esto implica interconectar más centros de datos en el borde.

Equilibrio entre el consumo de energía eléctrica y la sustentabilidad

La IA avanza a un ritmo cada vez más rápido, creando nuevas oportunidades y desafíos que abordar. Por ejemplo, los modelos de IA que utilizan DL y redes neuronales artificiales se caracterizan por su alto consumo de energía en su fase de entrenamiento de LLM que demanda enormes cantidades de electricidad. Esto irá en aumento a medida que los modelos se vuelvan más complejos y requieran cada vez más capacidades de redes, almacenamiento y computación.

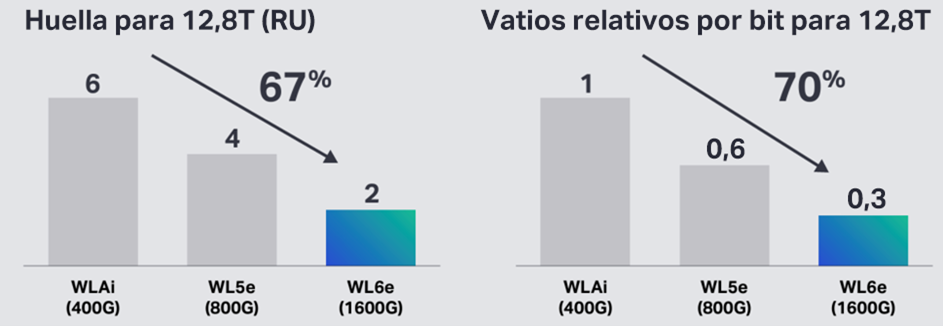

Figura 5: La innovación con WaveLogicTM de Ciena mejora constantemente el ahorro de espacio y energía por bit

Aunque los recursos de computación y almacenamiento de la infraestructura de IA consumen mucha más energía eléctrica que las redes que los interconectan, el crecimiento del ancho de banda de la red no puede escalar linealmente con el consumo de energía asociado: esto no resulta sustentable ni rentable. Esto significa que la tecnología de redes también debe reducir en forma constante la energía eléctrica (y el espacio) por bit para “hacer su parte” en un sector tan crucial para impulsar las capacidades de IA. La figura 5 muestra cómo la evolución constante de la tecnología WaveLogicTM de Ciena aumenta la eficiencia espectral alcanzable, al mismo tiempo que reduce la energía y el espacio necesarios por bit.

Los datos de IA solo son valiosos si pueden moverse

Dejando de lado el revuelo, la IA proporcionará beneficios sin precedentes en diferentes sectores que tendrán un impacto positivo en nuestras vidas profesionales y personales. Sin embargo, la adopción rápida y generalizada de la IA plantea una serie de nuevos desafíos relacionados con su infraestructura fundamental que incluye los componentes esenciales de computación, almacenamiento y redes. Abordar con éxito estos desafíos requiere una amplia innovación y colaboración intersectorial, ya que la IA solo escalará de manera efectiva si los datos pueden moverse de forma segura, sustentable y rentable desde el interior de los centros de datos en el núcleo donde se realiza el entrenamiento de LLM de IA hasta los centros de datos en el borde donde se encuentra la inferencia de IA.